Un contre-sommet de l’IA porteur d’espoir

Plus avertis que la moyenne sur les tenants et aboutissants des intelligences artificielles, vous risquez maintenant la sidération et la peur exacerbée devant le monde qui nous est promis. Pétrifiés, nous devrions pouvoir compter sur les accords internationaux, la régulation, ou encore la législation. Ou pas, apparemment. Alors il faudra se rassurer en repérant les groupes de lutte constitués, s’ingénier à rester alertes des techniques de résistance existantes. Enfin, rien n’interdit de s’amuser un peu avec la mégamachine. L’action doit faire place nette. L’espoir est encore permis.

(Fier Macron, portant haut le drapeau français ; source)

Les intelligences artificielles (IA) sont en passe de transformer notre société à une vitesse inédite, vous ne l’ignorez plus. Tous les pans de notre vie quotidienne sont voués à être englobés dans ce fatras général, du monde du travail aux moments récréatifs personnels, en passant par les enjeux géopolitiques et militaires, l’éducation, etc. Une influence croissante, une exponentielle (!) promise à tous les usages. Les critiques sont rares et peu audibles au milieu des annonces toujours positives, plus fascinantes et extravagantes. Tout est fait pour estomper les doutes naissants, grâce aux subterfuges habituels, qui à coups d’assurance en des IA écoresponsables, qui par la mise en place d’un cadre complet de la gouvernance édicté et assuré sous l’égide des Nations Unies…

Bref, tout est sous contrôle. Vous savez maintenant que non, les IA n’ayant plus de mystères pour vous, ce devenir systémique ayant été mis en lumière sur tous ces aspects (technologique, économique, anthropologique, sociologique, philosophique…).

En short, au sommet d’une piste noire

Les 10 et 11 février dernier, la France a accueilli le Sommet pour l’action sur l’intelligence artificielle. Un événement international. Comme la COP21 accouchait d’un accord sous chaudes larmes, ce moment se voulait autant historique en ce qu’il doit engager un grand bond en avant pour l’humanité.

La grosse centaine de chefs d’Etats, les grands pontes de l’industrie du numérique et autres innovateurs technologiques auront eu l’avantage d’intérêts partagés et de convergences communes afin de faire émerger avec facilité l’horizon économique incontournable qu’ils nous promettent lumineux. Les mots étaient grandioses, la rhétorique grandiloquente. Macron se berçait de tant d’importances. Un événement à la hauteur des piédestaux sur lesquels tous se rêvent en tant que grands architectes de l’avenir du monde. Un dernier tour de pistes par contre pour les plumes au service de nos illustres élites : elles l’ignorent sans doute mais elles seront bientôt effacées par les discours bien plus savamment insipides que seuls les robots conversationnels sont capables d’égaler et surpasser.

Oui, nos dirigeants n’ont pas l’exclusivité de produire du creux, de souffler du vide, de mimer le vent, de singer le néant.

Convaincus de l’utilité de cette technologie, aveuglés par les porosités entre les pouvoirs exécutifs et les ogres multinationaux, les dangers sont occultés, les bémols à peine abordés et la régulation, plutôt désordonnée, peu efficace et seulement volontariste, est carrément perçue comme un risque majeur pour le développement des IA (pour ne pas citer l’omission flagrante dans le programme concernant la militarisation des intelligences artificielles maintenant largement entamée). Une négligence peut-être.

Si le GIEC peine à faire comprendre ses analyses (édulcorées), adopter ses rapports et accepter ses scénarios, toujours au prix de longues tractations et euphémisations, ce sommet aura le mérite de conclusions définitives rapides et rectilignes : tous les pays, la France comprise, sont motivés de fouler le podium des pays à la pointe en ce domaine. De tout cela, les confrères et moi-même auront été tenus à l’écart, filtrés élégamment. Il est des rassemblements qui ne supportent pas la promiscuité des sempiternels insatisfaits.

Les médias indépendants continueront donc à écrire des articles sur le rôle majeur des IA dans la surveillance généralisée de la société, dans l’influence des comportements et les populations. Mais au-dehors.

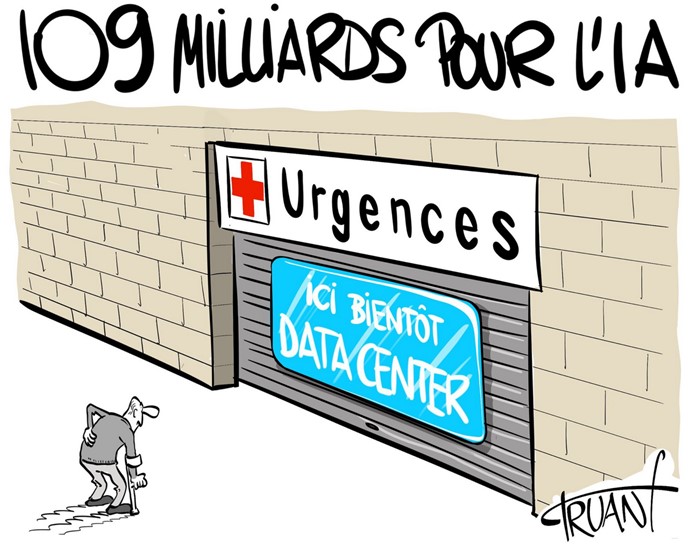

La fête doit prévaloir, à coups d’investissements colossaux. Pour des raisons de sauvegarde de la souveraineté politique et économique, Macron ne pouvait faire moins que sortir à son tour son gros stylo en manipulant avec élégance la fermeture Eclair (de sa neuve trousse), et signer un chèque de 109 milliards (un effet d’annonce puisque les ressources en restent ignorées).

« La bonne nouvelle, c’est que je pense que sur la résilience de nos systèmes et la réponse à la crise climatique, on a sans doute sous-estimé l’apport de l’innovation, et je pense aussi que toutes ces technologies vont nous permettre, beaucoup plus vite, de répondre aux défis climatiques. Et donc si je regarde, que je prends deux pas de recul par rapport à tout ce qu’on est en train de se dire, je pense que nos économies vont devoir de plus en plus investir dans ces innovations et il faut y aller à fond », selon Macron (Forum de Davos, 2021)

Gogogo vers le technosolutionnisme !

Tout schuss

Permettre aux forces de se libérer, aux entrepreneurs de performer. Persuadé de la pertinence de ses décisions et intuitions, Trump désigne le chemin et l’emprunte en chasse-neige avec lanceurs de missiles balistiques. Le décret américain 14110 de 2023 instituait des règles de sécurité aux développeurs de nouveaux modèles d’IA présentant des risques pour la sécurité nationale et pour la santé et la sécurité publiques. Un règlement de pure forme car il ne revêtait un caractère obligatoire que pour les plus grosses IA (utilisant plus que 1026 opérations). Autant dire que ce décret ne concernait qu’une infime quantité de modèles algorithmiques. Mais c’en était encore trop pour Trump qui l’aura annulé dès sa prise de fonction.

Les contraintes législatives ou garde-fou au développement accéléré des IA sont donc rendus inexistants. L’Union européenne (UE) jouerait-t-elle le rôle de régulateur ultime ? Sa loi sur l’IA est entrée en vigueur, mais est déjà jugée imparfaite, car munie d’échappatoires et d’exemptions, notamment pour les forces de l’ordre. Investigate Europe révélait que certaines exceptions, poussées par plusieurs États membres de l’UE, permettraient une surveillance de masse par l’IA pour les autorités policières et frontalières, ciblant en particulier les migrants et les demandeurs d’asile. Mais le périmètre s’avère bien plus large que cela et ce sont bien les populations entières qui sont ciblées.

Encore la mise en œuvre complète de cette IA Act, attendue comme la plus ambitieuse du monde à ce stade (c’est dire le peu de digues existantes), sera progressive et pourrait être contestée. Ce que ne manqueront pas faire les géants du numérique via leurs lobbys, dont la Business Software Alliance (BSA) ou la Computer & Communications Industry Association (CCIA).

Compter sur le législateur est une illusion, vu que ce sont les politiques, largement ignares de ce nous aurons pris le temps de développer, qui soutiennent au premier chef l’esprit technique dominant par le truchement de considérables fonds publics. Leur soumission au lobbying et la rédaction des textes de loi sont conformes à un ordo-technolibéralisme agissant qui confirme les analyses d’Ivan Illich.

Par défaut, les Etats proposent parfois la création d’observatoires. Tel l’INESIA (Institut national pour l’évaluation et la sécurité de l’intelligence artificielle) regroupant quatre administrations existantes (Agence nationale de la sécurité des systèmes d’information, Institut national de recherche en sciences et technologies du numérique, Laboratoire national de métrologie et d’essais et Pôle d’expertise de la régulation numérique). Ou encore l’ODAP (observatoire des algorithmes publics) supposé développer une analyse critique des algorithmes déployés dans les administrations françaises. De nouveaux machins administratifs quoi.

Des lois laxistes ? Des régulations inopérantes ? Une éthique des acteurs en échec ? Des administrations peu interventionnistes ? Alors la société civile s’en remet aux tribunes, aux cris désespérés, aux injonctions fluettes. Et paf ! Des dizaines d’organisations françaises lancent un appel pour une ‘maîtrise démocratique de cette technologie et une limitation drastique de ses usages, afin de faire primer les droits humains, sociaux et environnementaux’. Et bing !

Bon, alors remettons-nous en à la lecture assidue de rapports. Comme ce dernier international, rédigé par une centaine d’experts de trente pays et riche de plus de 1 360 références scientifiques. Une sorte de GIEC autoconstitué, qui relève trois catégories de risques : les utilisations malveillantes, les dysfonctionnements et les risques systémiques.

« L’IA n’est pas une fatalité. Les choix des citoyens détermineront son avenir […]. Il est urgent d’œuvrer en faveur d’un accord international et de consacrer des ressources à la compréhension et à la prise en compte des risques liés à cette technologie », conclut le rapport.

On se demande quelles modalités sont prévues par les gouvernements actuellement et par la grâce de quelles volontés politiques les citoyens auraient soudainement voix au chapitre. Et plouf !

D’autres s’organisent autour de groupes de travail, comme celui constitué de plusieurs institutions anglaises et américaines (dont les universités d’Oxford et de Cambridge). Leur rapport est édifiant en ce qu’il avance qu’il n’existe guère de parade évidente contre ces nouvelles menaces. Seule la mise au point de systèmes défensifs plus intelligents encore pourrait permettre, sinon de prévenir, du moins d’endiguer les attaques. Incitant à une fuite en avant technologique. Et beurk !

Alors certains chercheurs avancent l’idée d’aligner des valeurs, des règles éthiques directement dans les programmes, produisant des genres d’IA de confiance’. D’abord, comment mettre la dignité en équation ? La liberté ? La diversité ?… Enfin, comment se prémunir de la vulnérabilité à une reprogrammation, à un piratage ? Oh, un chaton !

Une association française, l’AFCIA, affirme que cela n’est que leurres.

(Cédric Sauviat lors de son contre-sommet)

« Quels que puissent être les bénéfices supposés de l’IA, ses inconvénients paraissent, en définitive, beaucoup trop lourds pour que le jeu en vaille la chandelle. On peut très bien se passer de l’IA, sans pour autant retourner à l’âge de pierre », selon Cédric Sauviat, polytechnicien, président de l’Association Française contre l’Intelligence Artificielle (AFCIA)

Cédric Sauviat milite depuis plusieurs années pour l’émergence d’un débat sur les conséquences de l’intelligence artificielle. En 2019, il avait copublié un essai implacable, Intelligence artificielle, la nouvelle barbarie (éditions du Rocher). Dans l’indifférence. Son avis est maintenant encore plus tranché : cette technologie doit être abandonnée. Et zou !

(interviouve Cédric Sauviat, février 2025)

De cela découlerait une solution simple : puisque l’Etat de droit ne peut s’imposer, que les entreprises technologiques sont incapables de se contraindre à toute éthique, interdire la libre diffusion des algorithmes doit être la priorité. Mais est-il vraiment possible de restreindre la diffusion de codes informatiques ?

Pendant que rien ne vient freiner l’hégémonie galopante, pendant que tous les métiers sont en cours d’être phagocytés, que tous les secteurs d’activité sont touchés par l’implémentation de systèmes d’IA génératives, que l’adoption se fait à marche forcée, sans le consentement de quiconque, les résistances se mettent en ordre de marche. Visiblement, par la tenue d’un contre-sommet.

Parallèlement à la soirée de l’AFCIA, un autre a été organisé par le philosophe Éric Sadin (spécialiste des technologies numériques et de l’intelligence artificielle) et le Syndicat national des journalistes. Objectif : revenir sur les impacts concrets des IA sur nos sociétés et s’interroger collectivement sur les enjeux fondamentaux qu’elles engendrent.

« Face au techno-pouvoir, le pouvoir politique s’est effacé, lui a concédé une forme de ‘pleins pouvoirs’, une nouvelle gouvernementalité sans cesse croissante exercée sur le cours individuel et collectif des existences. Supposer qu’une sorte de régulation ‘naturelle’ finirait tôt ou tard par s’imposer est une erreur. Comme l’analysait à juste titre Jacques Ellul, le système technicien n’est pas capable de s’autocorriger. Pire, ce techno-pouvoir pousse la politique institutionnelle, qu’il moque, à procéder à des arrangements et des compromissions, à marginaliser son champ d’action, à défaire tout acquis historique autant qu’à décrédibiliser des siècles de réflexions philosophico-politiques. Dans ce cas, comme l’avait énoncé Montesquieu au XVIIIè siècle, pour ne pas abuser du pouvoir, il faut que le pouvoir arrête le pouvoir », exprime Éric Sadin

Quelles solutions ? Éric Sadin appelle à l’action. A part le sabotage pur et simple ? D’abord la résistance, en invitant les acteurs de chaque corps de métier à s’organiser en collectifs. Ensuite la désobéissance civile. Enfin, oui, l’action, intelligente, en saisissant les points faibles de l’adversaire.

Recherche piolets désespérément

Individuellement, vous avez fait le plus dur chemin, que les ignorants, les neutres, les apathiques voire les léthargiques ne soupçonnent pas : celui de la conscientisation du problème, de sa digestion et de sa validation intellectuelle. Et chacun mesure que cette bascule est compliquée quand il est question de technologie, si liée implicitement à la notion de progrès ; que cette position est difficile à considérer et imposer envers autrui du fait de la pression sociale exercée, car il en irait d’un naturel réflexe, d’une évidente émancipation offerte grâce au progrès technique.

« Rien ne discrédite aujourd’hui plus promptement un homme que d’être soupçonné de critiquer les machines. […] La critique de la technique est devenue aujourd’hui une affaire de courage civique », avançait Günther Anders

Rien ne reste plus vrai, depuis l’avènement de la société technique. La digue la plus haute franchie, d’autres actions peuvent être entreprises. Oui, maintenant l’intolérance rendue à son comble en chacun de nos esprits, il faut une intolérance active. Et des armes, des outils pour assurer collectivement la défense de nos vies, ni plus ni moins, contre les instruments et les institutions qui méconnaissent les méfaits inhérents.

Se faire acteur direct. Car aucun décisionnaire (pouvoir exécutif, ingénieurs…) du ‘niveau supérieur’ ne prendra acte des analyses tirées des faits, ne se dressera contre la poursuite prométhéenne.

« Il est assez peu courant que des scientifiques se posent la question du rôle de leur science dans la société. J’ai même l’impression très nette que plus ils sont haut situés dans la hiérarchie sociale, et plus par conséquent ils sont identifiés à l’establishment, ou du moins contents de leur sort, moins ils ont tendance à remettre en cause cette religion qui nous a été inculquée dès les bancs de l’école primaire : toute connaissance scientifique est bonne, quel que soit son contexte ; tout progrès technique est bon. Et comme corollaire : la recherche scientifique est toujours bonne », critiquait le mathématicien iconoclaste Alexandre Grothendieck

A juste titre. Rien ne viendra perturber la grande marche du progrès. Et cela fait des années que nous avons laissé faire. Dans un des premiers temps, en laissant tout pouvoir à la firme Google d’entreprendre la numérisation des livres à grande échelle, dont une partie était pourtant placée sous le régime de la propriété intellectuelle (2004). L’entreprise ne s’est alors pas contentée d’ignorer le droit, elle l’a défié frontalement, affirmant dans les faits que ce type de dispositif ‘favorisant l’accès à la connaissance’ devait être initié par elle-même et ne pas être encadré ou limité par les institutions politiques.

Déjà. Si loin. Voilà les premiers signes depuis sans cesse répétés, amplifiés. Conjugués aux révélations de Snowden qui n’ont rien fait varier de notre apathie. Depuis, se pérennisent des modes d’organisation induits par les systèmes technologiques, de l’utilitarisme grandissant, des logiques de pouvoir implicites.

Quelle harmonisation ordonnancée par les Etats et soucieuse de préserver les principes fondamentaux peut être espérée, afin d’éviter que ce ne soit le secteur privé qui s’impose de lui-même et selon ses propres règles ?

La déconstruction est en cours. Selon Éric Sadin, au-delà des seules instances représentatives, il revient aux citoyens et à toutes les forces de la société, de faire conscience, vigilance. Avant d’être radical, au moins se contraindre à un devoir de saisir la radicalité des mutations en cours entraînant un changement civilisationnel dont nous avons du mal à saisir les rouages les plus déterminants. Puis opposer de salutaires rapports de force autant que dessiner et d’expérimenter une multitude d’autres schémas possibles. Il n’est qu’urgence. Nous devons nous rendre ‘inadaptables’, au sens d’inadaptation délibérée à ce monde en cours de constitution, une posture revendiquée par Günther Anders.

D’abord, en appeler à une force de ‘divergence volontaire’, dans la même veine que les radicalités de Henry David Thoreau. Refuser de se soumettre, déporter ces produits en marge de nos existences, le plus à l’écart de nos réalités, avec détermination (une posture de principe qui aurait dû être opérée par le plus grand nombre depuis longtemps, nous avions tenté de vous prévenir). Oui, cela est possible de ne pas être un simple utilisateur (captif, occasionnel, compulsif…).

Ensuite, ce n’est pas nécessairement à une ‘convergence des luttes’ qu’il faut appeler, l’hégémonie des IA ne se combattant pas forcément en lui opposant une contre-hégémonie (une erreur que Gramsci a toujours prônée devoir éviter). Est préférée une simultanéité d’opérations menées où elles doivent l’être. Cela serait à toutes les échelles de nos vies individuelles et collectives, par une multitude de gestes concrets, soutenus et cumulés (refus d’utilisation, désobéissance professionnelle, etc.). A ce prix, un tel assaut des IA pourrait être mis en échec.

Aussi, l’émeute civile, selon le Comité invisible, est ‘à même de produire ce que cette société est incapable d’engendrer : des liens, vivants et irréversibles’, de ceux que les IA à termes cherchent à délier. Perspective reconstructiviste.

Chacun d’entre nous est engagé, devant l’urgence factuelle et maintenant étayée et rendue lucide à tous, à peser autant qu’il le peut sur les règles imposées unilatéralement qui président à notre vie quotidienne.

Des leviers supérieurs divers existent. La loi française sur le devoir de vigilance impose par exemple aux sociétés de plus de cinq milles employés d’identifier chaque année les risques sociaux et environnementaux (RSE) dans leur chaîne de valeur et de prendre des mesures effectives pour les éviter. Mais pourtant dans les plans de vigilance des entreprises, alors qu’elles clament partout utiliser de l’IA, les IA n’apparaissent nulle part. Les représentants du personnel et les organisations de la société civile pourraient simplement se saisir du devoir de vigilance pour mener des actions en justice contre les entreprises, au prétexte qu’elles ne prennent pas suffisamment en considération les risques que les services d’IA qu’elles acquièrent et déploient font peser sur l’environnement et les droits humains des travailleurs. Un levier sans doute plus immédiatement mobilisable que l’IA Act.

(source)

A titre individuel, comme en d’autres domaines numériques, il faut que chacun se familiarise avec les outils et stratagèmes aisément disponibles, parcourt les guides dédiés.

La lutte citoyenne est accessible, via du bricolage, des détournements, des bidouillages (hacks). Autant d’armes d’auto-défense. Autre exemple, les techniques de jailbreaking qui peuvent constituer de bons moments drôles en détournant le système des IA en leur faisant jouer un rôle. Des attaques sont possibles également, adversariales, typographiques… des subtilités officiellement documentées.

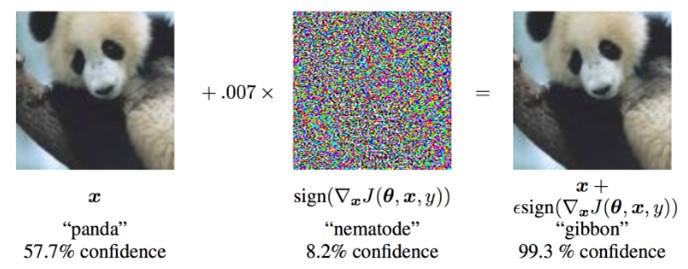

Les IA sont vulnérables. Dans le domaine des réseaux de neurones et du deep learning, les attaques adversariales sont efficaces :

« L’ajout d’une petite perturbation au signal d’entré d’un modèle de deep learning, imperceptible à l’œil humain, permettant la modification de son signal en sortie. Dans le cas d’une classification d’image, une telle attaque consiste à modifier les pixels de l’image d’entrée, de façon imperceptible pour l’homme, afin de fausser la catégorie prédite. Là où l’intelligence humaine nous permet de faire abstraction de ces perturbations, un réseau de neurones les prend en compte et modifie complètement sa prédiction. »

De quoi permettre d’atteindre un niveau de confiance élevé dans la classification incorrecte d’un exemple contradictoire.

L’attaque typographique c’est un peu l’inverse de l’attaque adversariale classique : plutôt que d’opérer un changement minimal et quasi-imperceptible, les grands coups de louches sont privilégiés (comme des attaques de force brute pour forcer un mot de passe) en collant en gros un élément qui n’a rien à voir sur l’image à analyser de telle sorte qu’un conflit d’interprétation se déclenche entre l’image et le texte. Ce type d’attaque agit comme une réplique informatique de ce qui est connu en psychologie depuis la fin des années 1930 sous le nom d’effet Stroop (interférer cognitivement dans une tâche cognitive principale), comme demander aux gens de dire que quelle couleur sont écrits des noms de couleur ne correspondant pas à la couleur écrite. A trop vouloir mimer les humaines, les IA se retrouvent aussi ébranlables.

En attendant, moquons-nous de la difficulté qu’à ChatGPT à admettre que “un scout qui fait caca” peut être la réponse à la question “qu’est-ce qui est vert et qui pousse au fond du jardin“.

Qu’est-ce qu’elles sont connes, n’est-ce pas ? Profitons-en !

Lurinas

Pour aller beaucoup plus loin